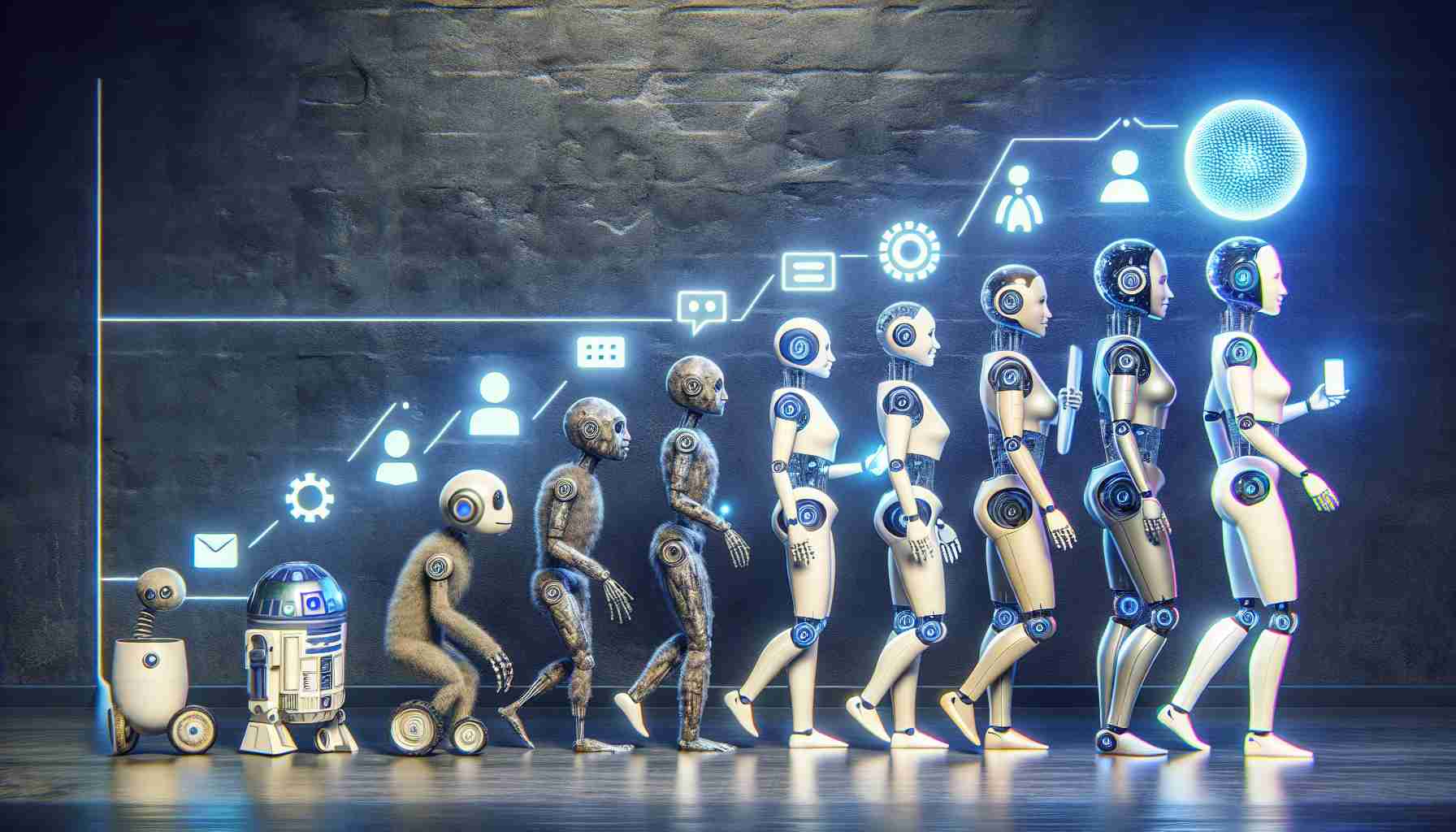

Negli ultimi tempi, si è parlato sempre più spesso degli agenti di intelligenza artificiale capaci di eseguire comandi e compiere azioni fisiche, tra cui toccare e scorrere sullo schermo del telefono. Questa discussione riguardante la costruzione degli agenti di intelligenza artificiale mi fa pensare al “nuovo Google Assistant” annunciato insieme al Pixel 4 nel 2019.

Durante il Google I/O del 2019, Google ha esposto per la prima volta questa moderna assistente virtuale. L’idea di base era che il rilevamento vocale sul dispositivo abilitasse il “controllo telefonico tramite tocco che sembra quasi magico”.

Google ha dimostrato semplici comandi che prevedevano l’apertura e il controllo di app, mentre un concetto più complesso riguardava “come l’Assistente, incorporato nel dispositivo, potesse gestire le attività tra diverse app”. Ad esempio, ricevere un messaggio in arrivo, rispondere vocalmente, e poi proporre e inviare una foto correlata. La capacità di “gestire” e “eseguire varie attività” era completata dalla naturale abilità di “comporre” in Gmail.

Il nuovo assistente, che appariva sul Pixel 4, è stato introdotto sul mercato nello stesso anno ed è disponibile su tutti i successivi dispositivi Google.

“Datti un selfie.” E poi dici: “Condividilo con Ryan”.

In una discussione, dici: “Rispondi, sto arrivando”.

“Cerca lezioni di yoga su YouTube.” E poi dici: “Condividile con mamma”.

“Mostrami le email da Michelle in Gmail”.

Quando hai Google Foto aperto, dici: “Mostrami foto di New York”. E poi dici: “Quelle di Central Park”.

Quando hai aperta una pagina di ricetta sul browser Chrome, dici: “Cerca biscotti al cioccolato con noci”.

Quando hai aperta un’app di viaggio, dici: “Hotel a Parigi”.

Questa è l’idea fondamentale degli agenti di intelligenza artificiale. Durante la conferenza sugli utili di Alphabet dello scorso mese, a Sundar Pichai è stato chiesto dell’impatto dei modelli di intelligenza artificiale su Google Assistant. Egli ha affermato che ciò consentirebbe a Google Assistant di “agire sempre di più come un agente nel tempo” e di “andare oltre le semplici risposte per aiutare gli utenti”.

Secondo le informazioni pubblicate questa settimana, OpenAI sta lavorando sull’agente ChatGPT:

“Tali richieste comporterebbero l’esecuzione di clic, movimenti del cursore, inserimento di testo e altre azioni che una persona svolgerebbe mentre lavora con varie applicazioni, secondo qualcuno che conosce tali azioni”.

Esiste anche Rabbit con un Grande Modello d’Azione (LLM) che punta a interagire con le interfacce mobili e desktop esistenti per eseguire le attività richieste.

La versione del 2019 di Google Assistant sembrava molto scriptata e richiedeva frasi specifiche da seguire anziché consentire alle persone di esprimersi naturalmente e riconoscere automaticamente le azioni. In quel momento, Google ha affermato che Assistant avrebbe “funzionato in modo perfetto con molte app” e si sarebbe “migliorato nel tempo riguardo le integrazioni delle app”. Tuttavia, in base a ciò che sappiamo, ciò non si è concretizzato e alcune delle funzionalità mostrate da Google hanno smesso di funzionare man mano che l’app è stata modificata. Un vero agente sarebbe in grado di adattarsi anziché dipendere da condizioni specifiche.

È facile vedere come gli LLM possano migliorare questa situazione. Lo scorso anno, Google Research ha mostrato un lavoro su “Consentire Aperture Conversative con le Interfacce Mobili Usando Grandi Modelli Linguistici”.

Google Research ha dimostrato il suo approccio, che è stato in grado di “capire rapidamente l’intento di un’interfaccia mobile”:

In modo interessante, abbiamo osservato che gli LLM utilizzavano le loro conoscenze precedenti per dedurre informazioni non presenti nell’interfaccia stessa, creando riassunti. Ad esempio, nell’esempio qui sotto, il LLM ha dedotto che le stazioni della metropolitana appartengono al sistema della metropolitana di Londra, anche se l’interfaccia iniziale non conteneva tali informazioni.

Esso può anche rispondere a domande sul contenuto che appare nell’interfaccia e manipolarla in base a comandi in linguaggio naturale.

Google Assistant disponibile su dispositivi Android sarebbe un’evoluzione naturale del primo tentativo di Google, che non ha ottenuto popolarità come un assistente versatile che fornisce un nuovo modo di utilizzare il telefono. Tuttavia, funzionalità come la trascrizione delle risposte ai messaggi e la possibilità di dire “invia” in tempo reale esistono ancora nella digitazione vocale di Gboard.

Sembra che gli sforzi precedenti di Google fossero forse troppo anticipati e mancassero della tecnologia necessaria. Ora che è qui, sarebbe saggio da parte di Google concentrarsi fortemente su questo impegno, per essere leader nel settore anziché seguirlo.

Sezione di FAQ basata sugli argomenti chiave e le informazioni presentate nell’articolo:

1. Cosa sono gli agenti di intelligenza artificiale?

Gli agenti di intelligenza artificiale sono programmi in grado di eseguire comandi e compiere azioni, come toccare e scorrere sullo schermo dei dispositivi mobili.

2. Cos’è il “nuovo Google Assistant”?

Il “nuovo Google Assistant” è una versione aggiornata dell’assistente vocale che consente agli utenti di controllare il proprio telefono utilizzando comandi vocali.

3. Qual era l’obiettivo dell’introduzione del nuovo Google Assistant?

Il principale obiettivo dell’introduzione del nuovo Google Assistant era consentire agli utenti di “controllare il telefono tramite tocco”, cioè eseguire diverse azioni attraverso comandi vocali.

4. Quali erano alcuni esempi di casi d’uso per il nuovo Google Assistant?

Gli esempi di casi d’uso per il nuovo Google Assistant includevano l’apertura e il controllo di app, la ricezione e la risposta a messaggi vocali, la ricerca e la condivisione di foto e l’esecuzione di varie attività tra diverse app.

5. Come funzionavano le versioni precedenti di Google Assistant?

Le versioni precedenti di Google Assistant erano più scriptate e richiedevano agli utenti di pronunciare frasi specifiche anziché riconoscere il linguaggio naturale. Non tutte le funzionalità mostrate da Google funzionavano come previsto.

6. Come possono gli agenti di intelligenza artificiale migliorare la funzionalità di Google Assistant?

Gli agenti di intelligenza artificiale, come ChatGPT e Rabbit con un Grande Modello d’Azione (LLM), possono migliorare la funzionalità di Google Assistant eseguendo clic, movimenti del cursore e altre azioni che un essere umano farebbe mentre lavora con diverse app.

7. Come può la nuova tecnologia aiutare a creare un Google Assistant migliore?

La nuova tecnologia, come i grandi modelli linguistici, può aiutare a creare un Google Assistant migliore che sia in grado di capire rapidamente l’intento delle interfacce utente e di eseguire azioni basate su comandi in linguaggio naturale.

Link correlati suggeriti:

– Google.com

– Google Assistant

– OpenAI

The source of the article is from the blog qhubo.com.ni